A Cerebras Systems acaba de anunciar a terceira geração de seu gigante “processador”, otimizado para treinamento de inteligência artificial. Com mais de 4 trilhões de transistores, o WSE-3 pode atingir 125 petaflops de potência computacional para tarefas relacionadas à IA.

Atualmente, a maior parte da inteligência artificial, por exemplo Bate-papoGPTBate-papoGPT Ou estável EspalharEspalhar, pode ser reproduzido em um PC topo de linha com uma boa placa gráfica. No entanto, o pré-treinamento requer mais energia para processar uma enorme quantidade de dados. Portanto, os supercomputadores especificamente concebidos para IA serão cada vez mais necessários à medida que os modelos de IA se tornam mais complexos.

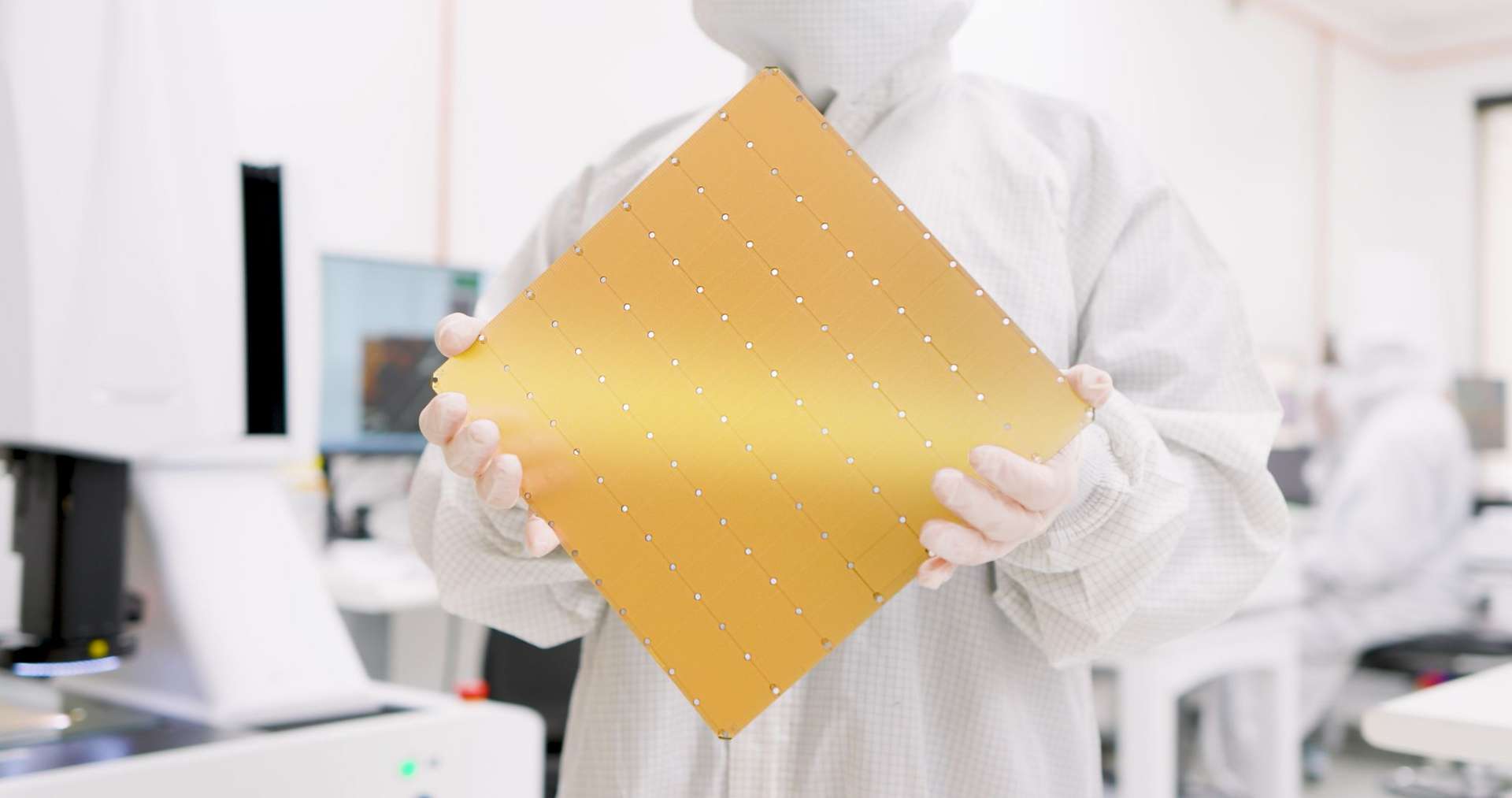

Para isso, a Cerebras Systems acaba de anunciar um novo chip de IA, que é o mais rápido do mundo. É composto por um total de 4.000 bilhões de transistores gravados com um processo de 5Vnmnm. Esta é a terceira geração dele Motor de escala wafer (WSE-3), ou seja, ocupa uma lasca Completo, placa SiliconeSilicone Que geralmente são divididos para formar processadores individuais.

Treinamento de inteligência artificial em um dia

O WSE-3 está integrado ao supercomputador Cerebras CS-3, que possui um total de 900.000 núcleos otimizados para IA com 44 GB de memória SDRAMSDRAM. Tudo isso pode ser combinado com até 1,2 petabytes de espaço de armazenamento. Segundo o fabricante, o CS-3 pode atingir até 125 petaflops (milhões de bilhões de operações de ponto flutuante por segundo). Para efeito de comparação, este é o mesmo poder do décimo supercomputador mais rápido do mundo. Esta máquina pode treinar modelos de IA com até 24 trilhões de parâmetros, mais de dez vezes seu tamanho GPT-4GPT-4 E GoogleGoogle gêmeo.

Melhor ainda, a Cerebras Systems anunciou que é teoricamente possível combinar até 2.048 desses chips para atingir 256 exaflops (ou 256.000 petaflops) de potência. Basta treinar o modelo Llama 70B do zero em um dia. Inicialmente, a empresa planeja construir um supercomputador chamado Condor Galaxy 3 contendo 64 sistemas CS-3, com potência de 8 exaflops.